中新網北京8月24日電 (記者 孫自法)國際著名學術期刊《自然》最新發表一篇計算科學論文,研究人員報道了一種能效為(wei) 傳(chuan) 統數字計算機芯片14倍的模擬人工智能(AI)芯片。研究顯示,這一由美國IBM研究實驗室開發的芯片在語音識別上的效率超過通用處理器,該項技術或能打破當前AI開發中因對算力性能和效率的需求而遇到的瓶頸。

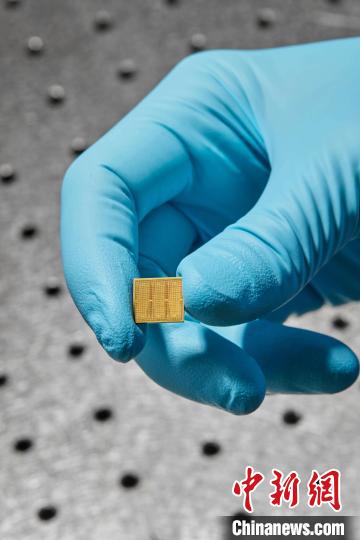

14納米模擬AI芯片在檢測板上(圖片來自Ryan Lavine)。施普林格·自然 供圖

該論文介紹,隨著AI技術的崛起,對能源和資源的需求也隨之上升。在語音識別領域,軟件升級極大提升了自動轉寫(xie) 的準確率,但由於(yu) 在存儲(chu) 器與(yu) 處理器之間移動的運算數量不斷增加,硬件無法跟上訓練和運行這些模型所需的數以百萬(wan) 計的參數。研究人員提出的一個(ge) 解決(jue) 辦法是使用“存內(nei) 計算”(CiM,或稱模擬AI)芯片。模擬AI係統通過直接在它自己的存儲(chu) 器內(nei) 執行運算來防止低效,而數字處理器需要額外時間和能源在存儲(chu) 器和處理器之間移動數據。模擬AI芯片預計能極大提升AI計算的能效,但之前對此的實際演示一直缺乏。

研究者手上拿著的14納米模擬AI芯片(圖片來自Ryan Lavine)。施普林格·自然 供圖

論文第一作者和通訊作者、IBM研究實驗室S. Ambrogio和同事開發了一個(ge) 14納米的模擬AI芯片,在34個(ge) 模塊(tile)中含有3500萬(wan) 個(ge) 相變化內(nei) 存單元。研究團隊用兩(liang) 個(ge) 語音識別軟件在語言處理能力上測試了該芯片的效率,這兩(liang) 個(ge) 軟件分別是一個(ge) 小網絡(Google Speech Commands)和一個(ge) 大網絡(Librispeech),並在自然語言處理任務上與(yu) 行業(ye) 標準進行對比。小網絡的性能和準確率與(yu) 當前的數字技術相當。對於(yu) 更大的Librispeech模型來說,該芯片能達到每秒每瓦12.4萬(wan) 億(yi) 次運算(Tera Operations),係統性能估計最高能達到傳(chuan) 統通用處理器的14倍。

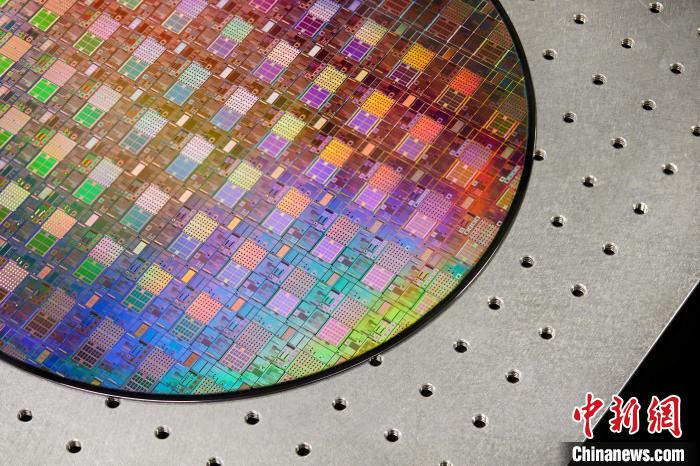

用來製造模擬AI芯片的300毫米晶圓(圖片來自Ryan Lavine)。施普林格·自然 供圖

《自然》同期發表同行專(zhuan) 家的“新聞與(yu) 觀點”文章稱,該研究在小模型和大模型中同時驗證了模擬AI技術的性能和效率,支持其有望成為(wei) 數字係統的商業(ye) 可行的替代選擇。(完)

版權聲明:凡注明“來源:新利平台”或“新利平台文”的所有作品,版權歸高原(北京)文化傳(chuan) 播有限公司。任何媒體(ti) 轉載、摘編、引用,須注明來源新利平台和署著作者名,否則將追究相關(guan) 法律責任。

新利平台微博

新利平台微博 新利平台微信

新利平台微信